Des chercheurs américains font danser le David de Michel-Ange pour étudier la création de vidéos photoréalistes

Si, en visitant la galerie de l’Accademia à Florence, vous vous êtes demandé, entre autres, comment se comporterait le David de Michel-Ange s’il se mettait à danser sur les notes de What is Love de Haddaway (ou sur n’importe quelle musique de danse), nous pouvons dire que votre curiosité est maintenant satisfaite. Un groupe de chercheurs de la NVIDIA Corporation (société américaine qui produit de célèbres processeurs graphiques, cartes vidéo et produits multimédias pour ordinateurs) a animé le chef-d’œuvre de Michel-Ange en le faisant danser : les auteurs de l’opération sont Ting-Chun Wang, Ming-Yu Liu, Andrew Tao, Guilin Liu, Jan Kautz et Bryan Catanzaro.

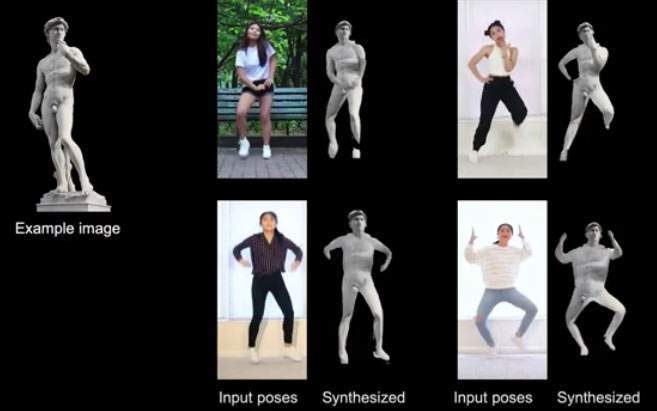

En fait, ce n’est pas que les six chercheurs n’avaient pas mieux à faire : leur David dansant a été utilisé pour tester un programme de synthèse vidéo-vidéo qui applique le mimétisme d’autres humains en chair et en os à des humains et à des objets (des statues, dans le cas du David). "La synthèse vidéo-vidéo (vid2vid), lit-on dans le résumé de l’article des chercheurs, vise à convertir une entrée vidéo sémantique, par exemple une vidéo de mouvements humains ou de masques de segmentation, en une vidéo photoréaliste. Mais ce n’est pas tout : l’étude vise également à surmonter, expliquent les chercheurs, deux limitations importantes de la synthèse vid2vid, à savoir le fait que de telles opérations nécessitent une énorme quantité de données pour garantir des résultats acceptables, et le fait qu’un modèle vid2vid a des capacités de généralisation limitées (c’est-à-dire qu’un modèle vid2vid ne peut être efficace que s’il est appliqué à la personne qui a posé, précisément, pour se prêter à être un modèle : en d’autres termes, un modèle vid2vid ne peut pas être utilisé pour créer des vidéos d’autres personnes).

Les travaux des chercheurs de la NVIDIA Corporation apprennent à synthétiser certaines entrées et à les transmettre à d’autres sujets que ceux qui ont “posé” pour servir de modèles au programme : le David qui se déplace sur la piste de danse est le résultat de cette importante recherche sur la création de vidéos réalistes. La même chose a été faite avec des photos de personnes qui se sont prêtées au test : avec deux entrées (une vidéo d’une figure dansante et des photos des personnes à animer), des vidéos réalistes ont été produites avec les sujets représentés sur les photos, qui se sont retrouvés (malgré eux, pourrions-nous dire) en train de danser sur de la musique disco. Le studio et une vidéo avec les animations de test sont disponibles sur ce lien.

En résumé, les études tentent de faire évoluer l’état de l’art sur les applications qui créent des images et des vidéos photoréalistes, qui donnent toutefois beaucoup de maux de tête, surtout si l’on pense aux problèmes concernant la vie privée et les deep fakes, c’est-à-dire les images réalistes (mais fausses) réalisées à partir de la photographie d’une personne réelle (il existe déjà, par exemple, des applications qui “déshabillent” littéralement une personne simplement en lui transmettant une photographie). Des vidéos comme celle de David dansant pourraient être la prochaine évolution (et, à bien y penser, quelque peu dérangeante).

|

| Des chercheurs américains font danser le David de Michel-Ange pour étudier la création de vidéos photoréalistes |

Avertissement : la traduction en français de l'article original italien a été réalisée à l'aide d'outils automatiques. Nous nous engageons à réviser tous les articles, mais nous ne garantissons pas l'absence totale d'inexactitudes dans la traduction dues au programme. Vous pouvez trouver l'original en cliquant sur le bouton ITA. Si vous trouvez une erreur,veuillez nous contacter.