Investigadores estadounidenses hacen bailar al ritmo del David de Miguel Ángel para estudiar la creación de vídeos fotorrealistas

Si al visitar la Galería de la Academia de Florencia te has preguntado, entre otras cosas, cómo se comportaría el David de Miguel Ángel si se pusiera a bailar al son de las notas de What is Love de Haddaway (o de cualquier música dance), podemos decirte que tu curiosidad ya está satisfecha. Un grupo de investigadores de NVIDIA Corporation (empresa estadounidense que fabrica los famosos procesadores gráficos, tarjetas de vídeo y productos multimedia para ordenadores) ha animado la obra maestra de Miguel Ángel haciéndola bailar: los autores de la operación son Ting-Chun Wang, Ming-Yu Liu, Andrew Tao, Guilin Liu, Jan Kautz y Bryan Catanzaro.

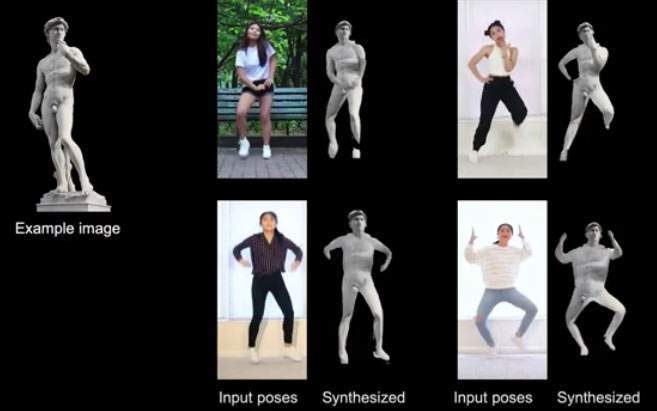

En realidad, no es que los seis investigadores no tuvieran mejores cosas que hacer: su David danzante sirvió para probar un programa de síntesis de vídeo a vídeo que aplica la mímica de otros humanos de carne y hueso a personas y objetos (estatuas, en el caso del David). “La síntesis de vídeo a vídeo (vid2vid)”, reza el resumen del trabajo de los investigadores, “pretende convertir una entrada semántica de vídeo, por ejemplo, un vídeo de movimientos humanos o máscaras de segmentación, en un vídeo fotorrealista”. No sólo eso: el estudio también pretende superar, explican los investigadores, dos graves limitaciones de la síntesis vid2vid, a saber, el hecho de que tales operaciones requieren una enorme cantidad de datos para garantizar resultados aceptables, y el hecho de que un modelo vid2vid tiene una capacidad de generalización limitada (es decir, un modelo vid2vid sólo puede ser eficaz si se aplica a la persona que posó, precisamente, para prestarse a ser modelo: en otras palabras, un modelo vid2vid no puede utilizarse para crear vídeos de otras personas).

El trabajo de los investigadores de la corporación NVIDIA aprende a sintetizar determinadas entradas y a transmitirlas a sujetos distintos de los que han “posado” para actuar como modelos del programa: el David que se mueve en la pista de baile es el resultado de esta importante investigación sobre la creación de vídeos realistas. También se hizo lo mismo con fotos de personas que se prestaron a la prueba: a partir de dos entradas (un vídeo de una figura bailando y fotografías de las personas a animar), se produjeron vídeos realistas de los sujetos retratados en las fotografías, que se encontraron (a su pesar, podríamos decir) bailando música disco. El estudio y un vídeo con las animaciones de prueba pueden consultarse en este enlace.

En pocas palabras, los estudios intentan hacer evolucionar el estado del arte de las aplicaciones que crean imágenes y vídeos fotorrealistas, que, sin embargo, dan muchos quebraderos de cabeza, sobre todo si pensamos en los problemas relativos a la privacidad y a los deep fakes, es decir, imágenes realistas (pero falsas) hechas a partir de la fotografía de una persona real (ya existen, por ejemplo, aplicaciones que “desnudan” literalmente a una persona con sólo pasarle una fotografía). Vídeos como el del David bailarín podrían ser la próxima (y, pensándolo bien, algo inquietante) evolución.

|

| Investigadores estadounidenses hacen bailar al ritmo del David de Miguel Ángel para estudiar la creación de vídeos fotorrealistas |

Advertencia: la traducción al español del artículo original en italiano se ha realizado mediante herramientas automáticas. Nos comprometemos a revisar todos los artículos, pero no garantizamos la ausencia total de imprecisiones en la traducción debidas al programa. Puede encontrar el original haciendo clic en el botón ITA. Si encuentra algún error, por favor contáctenos.