Wenn Sie sich beim Besuch der Accademia-Galerie in Florenz u. a. gefragt haben, wie sich Michelangelos David verhalten würde, wenn er zu den Noten von Haddaways What is Love (oder irgendeiner anderen Tanzmusik) zu tanzen beginnen würde, können wir sagen, dass Ihre Neugier jetzt befriedigt ist. Eine Gruppe von Forschern der NVIDIA Corporation (ein amerikanisches Unternehmen, das berühmte Grafikprozessoren, Videokarten und Multimediaprodukte für Computer herstellt) hat Michelangelos Meisterwerk animiert, indem sie es zum Tanzen gebracht haben: Die Autoren der Operation sind Ting-Chun Wang, Ming-Yu Liu, Andrew Tao, Guilin Liu, Jan Kautz und Bryan Catanzaro.

Nicht, dass die sechs Forscher nichts Besseres zu tun gehabt hätten: Ihr tanzender David diente dazu, ein Video-to-Video-Syntheseprogramm zu testen, das die Mimikry anderer Menschen aus Fleisch und Blut auf Menschen und Objekte (im Fall des David) anwendet. “Video-zu-Video-Synthese (vid2vid)”, heißt es in der Zusammenfassung der Forscher, "zielt darauf ab, einen semantischen Video-Input, z. B. ein Video mit menschlichen Bewegungen oder Segmentierungsmasken, in ein fotorealistisches Video zu konvertieren. Und nicht nur das: Die Studie zielt auch darauf ab, zwei schwerwiegende Einschränkungen der vid2vid-Synthese zu überwinden, erklären die Forscher, nämlich die Tatsache, dass solche Operationen eine riesige Datenmenge benötigen, um akzeptable Ergebnisse zu garantieren, und die Tatsache, dass ein vid2vid-Modell nur begrenzte Verallgemeinerungsfähigkeiten hat (d.h. ein vid2vid-Modell kann nur dann effektiv sein, wenn es auf die Person angewendet wird, die sich gerade als Modell zur Verfügung gestellt hat: Mit anderen Worten, ein vid2vid-Modell kann nicht verwendet werden, um Videos von anderen Personen zu erstellen).

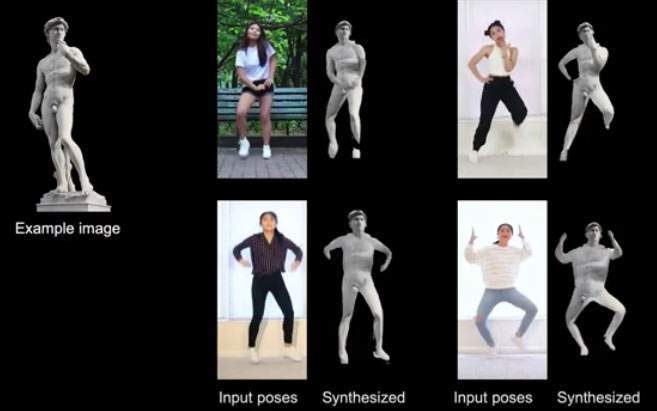

Die Forscher der NVIDIA Corporation lernen, wie man bestimmte Inputs synthetisiert und sie dann an andere Personen weitergibt, die nicht als Modell für das Programm “posiert” haben: Der David, der sich auf der Tanzfläche bewegt, ist das Ergebnis dieser wichtigen Forschung zur Erstellung realistischer Videos. Dasselbe wurde auch mit Fotos von Personen gemacht, die sich für den Test zur Verfügung stellten: Mit zwei Inputs (einem Video einer tanzenden Figur und Fotos der zu animierenden Personen) wurden realistische Videos von den auf den Fotos abgebildeten Personen produziert, die sich (sozusagen trotz ihrer selbst) beim Tanzen zu Discomusik wiederfanden. Das Studio und ein Video mit den Testanimationen finden Sie unter diesem Link.

Kurz gesagt, die Studien versuchen, den Stand der Technik bei Anwendungen weiterzuentwickeln, die fotorealistische Bilder und Videos erstellen, die jedoch viel Kopfzerbrechen bereiten, vor allem wenn man an die Probleme in Bezug auf die Privatsphäre und Deep Fakes denkt, d. h. realistische (aber gefälschte) Bilder, die aus dem Foto einer realen Person erstellt werden (es gibt zum Beispiel bereits Anwendungen, die eine Person buchstäblich “ausziehen”, indem sie ihr einfach ein Foto vorlegen). Videos wie das des tanzenden David könnten die nächste (und, wenn man es recht bedenkt, etwas verstörende) Entwicklung sein.

|

| US-Forscher lassen Michelangelos David im Takt tanzen, um die Erstellung von fotorealistischen Videos zu untersuchen |

Achtung: Die Übersetzung des italienischen Originalartikels ins Deutsche wurde mit Hilfe automatischer Tools erstellt. Wir verpflichten uns, alle Artikel zu überprüfen, aber wir garantieren nicht die völlige Abwesenheit von Ungenauigkeiten in der Übersetzung aufgrund des Programms. Sie können das Original finden, indem Sie auf die ITA-Schaltfläche klicken. Wenn Sie einen Fehler finden, kontaktieren Sie uns bitte.