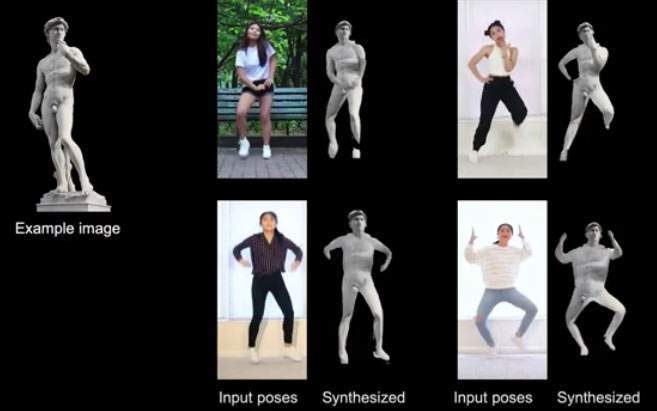

Ricercatori USA fanno ballare il David di Michelangelo al ritmo di dance per studiare la creazione di video fotorealistici

Se visitando la Galleria dell’Accademia a Firenze vi siete domandati, tra le altre cose, come si comporterebbe il David di Michelangelo se dovesse mettersi a ballare sulle note di What is love di Haddaway (o su un qualsiasi brano di musica dance), possiamo dire che la vostra curiosità da oggi è soddisfatta. Un gruppo di ricercatori della NVIDIA Corporation (un’azienda statunitense che produce celebri processori grafici, schede video e prodotti multimediali per computer) ha animato il capolavoro michelangiolesco facendolo ballare: autori dell’operazione sono Ting-Chun Wang, Ming-Yu Liu, Andrew Tao, Guilin Liu, Jan Kautz e Bryan Catanzaro.

In realtà non è che i sei ricercatori non avessero di meglio da fare: il loro David ballerino è stato utilizzato per testare un programma di sintesi video-to-video che applica a esseri umani e oggetti (statue, nel caso del David) la mimica di altri esseri umani in carne e ossa. “La sintesi ‘video-to-video (vid2vid)’”, si legge nel sunto del paper dei ricercatori, “ha l’obiettivo di convertire un input video semantico, per esempio un video di movimenti umani o delle maschere di segmentazione, in un video fotorealistico”. Non solo: lo studio si pone anche lo scopo di superare, spiegano i ricercatori, due pesanti limiti della sintesi vid2vid, ovvero il fatto che operazioni del genere richiedono una mole enorme di dati per poter garantire risultati accettabili, e il fatto che un modello vid2vid ha limitate capacità di generalizzazione (ovvero, un modello vid2vid può essere efficace solo se applicto alla persona che ha posato, appunto, per prestarsi a fare da modello: in altre parole, un modello vid2vid non può essere utilizzato per creare video di altre persone).

Il lavoro dei ricercatori della NVIDIA Corporation impara a sintetizzare alcuni input per poi trasmetterli a soggetti diversi da quelli che hanno “posato” per fare da modelli al programma: il David che si muove sul dancefloor è il risultato di queste importanti ricerche nell’ambito della creazione di video realistici. La stessa cosa è stata fatta anche con foto di persone che si sono prestate al test: dati due input (un video di una figura che balla e le fotografie delle persone da animare), sono stati prodotti videorealistici dei soggetti ritratti nelle fotografie, che si sono ritrovati (loro malgrado, potremmo dire) a ballare musica da discoteca. A questo link si trovano lo studio e un video con le animazioni di test.

In poche parole, gli studi stanno cercando di far evolvere lo stato dell’arte sulle applicazioni che creano immagini e video fotorealistici, e che però dànno moltissimi grattacapi soprattutto se pensiamo ai problemi riguardanti la privacy e i deep fake, ovvero le immagini realistiche (ma finte) realizzate a partire dalla fotografia di una persona vera (esistono già, per esempio, applicazioni che letteralmente “spogliano” una persona semplicemente dando loro in pasto una fotografia). Video come quello del David che balla potrebbero essere la successiva (e, a pensarci bene, un po’ inquietante) evoluzione.

|

| Ricercatori USA fanno ballare il David di Michelangelo al ritmo di dance per studiare la creazione di video fotorealistici |

al prezzo di 12,00 euro all'anno avrai accesso illimitato agli articoli pubblicati sul sito di Finestre sull'Arte e ci aiuterai a crescere e a mantenere la nostra informazione libera e indipendente.

ABBONATI A

FINESTRE SULL'ARTE

Concorso MiBACT, la denuncia dei partecipanti: “in migliaia abbiamo rinunciato per la pessima organizzazione”

Venezia, i vigili cacciano pittore da piazza San Marco. Ma era Ken Howard, artista di fama internazionale